在GTC 2021上,有很多与GPU相关的公告,我们的测评还没有涵盖最新的NVIDIA A30,我们发现A30是我们特别感兴趣的产品,本文我们来讨论一下NVIDIA A30。

继续阅读

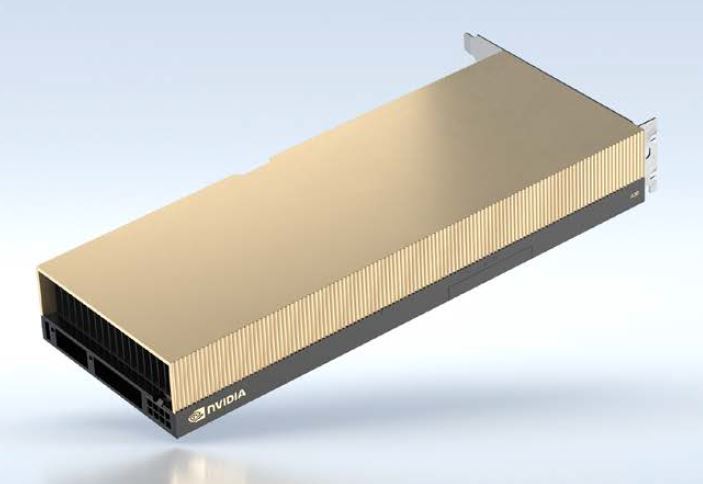

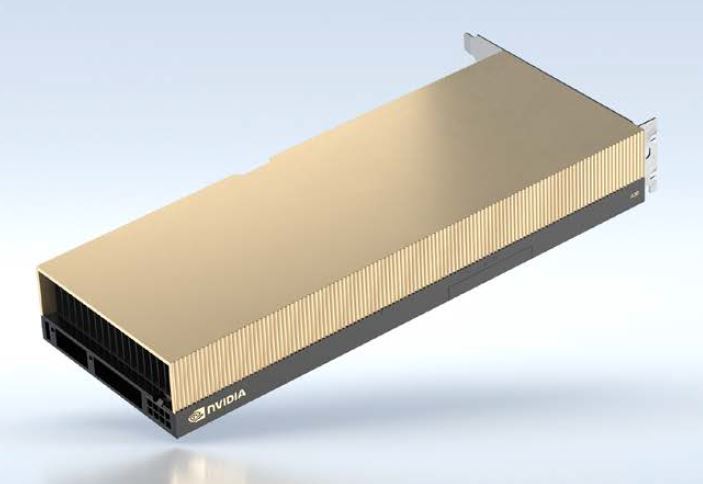

Google AI TPU

在GTC 2021上,有很多与GPU相关的公告,我们的测评还没有涵盖最新的NVIDIA A30,我们发现A30是我们特别感兴趣的产品,本文我们来讨论一下NVIDIA A30。

继续阅读

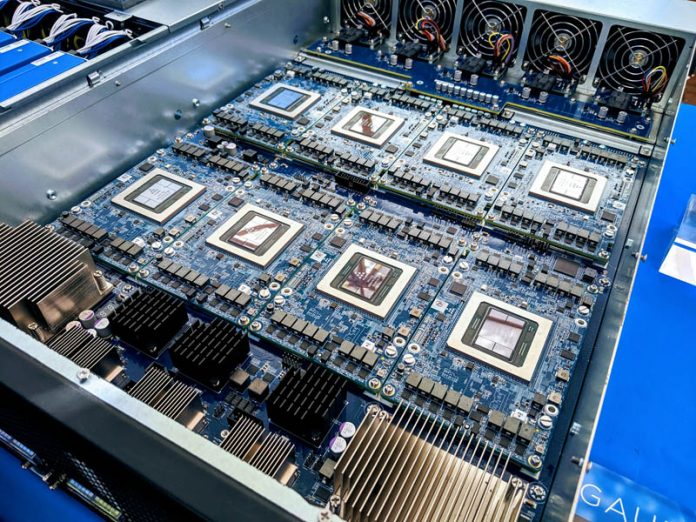

技嘉(Gigabyte) E251-U70是一款2U短深度的服务器,其设计旨在提供一个单Socket的边缘AI和网络平台。

继续阅读

NVIDIA认证服务器产品背后的基本思想是原始设备制造商可以在大量采用NVIDIA组件的系统配置上运行验证脚本,如果测试通过,OEM便可以宣称其系统是NVIDIA认证的

继续阅读

Xsight Labs是一家新创的网络公司,拥有超过1亿美元的投资,正试图打入下一代数据中心交换芯片的市场。该公司将赌注压在其最新的7nm芯片设计上,通过赢得超大规模/Tier 1的客户,将网络交换的核心芯片推向市场。他们的X1芯片已经在向客户提供样品。

继续阅读

12月3日消息,亚马逊(Amazon)云计算业务部门AWS与英特尔官网的信息显示,亚马逊弹性计算云(EC2)实例将采用英特尔旗下Habana Labs的Gaudi加速器。

继续阅读作为一种未来的新兴技术,我们一直在追踪的领域之一是硅集成光技术。在2020年Intel Labs Day上,Intel展示了其下一代硅光技术研究的方向。

继续阅读

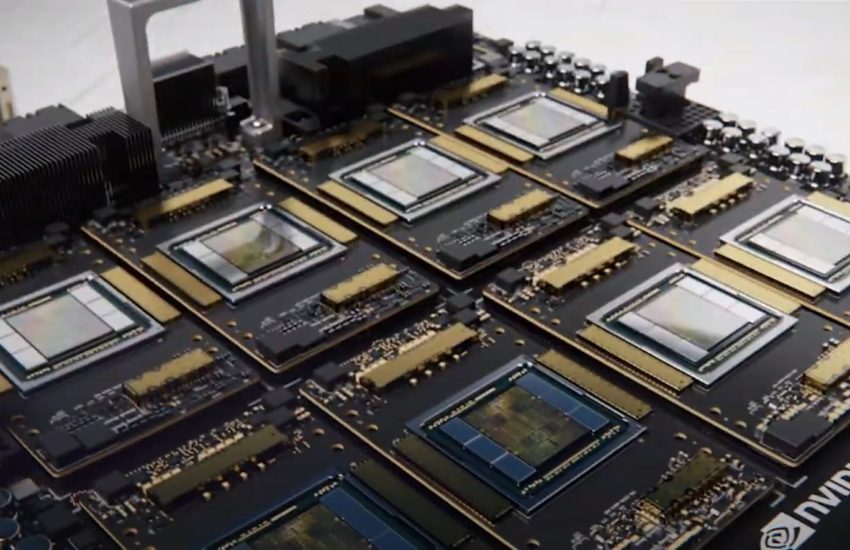

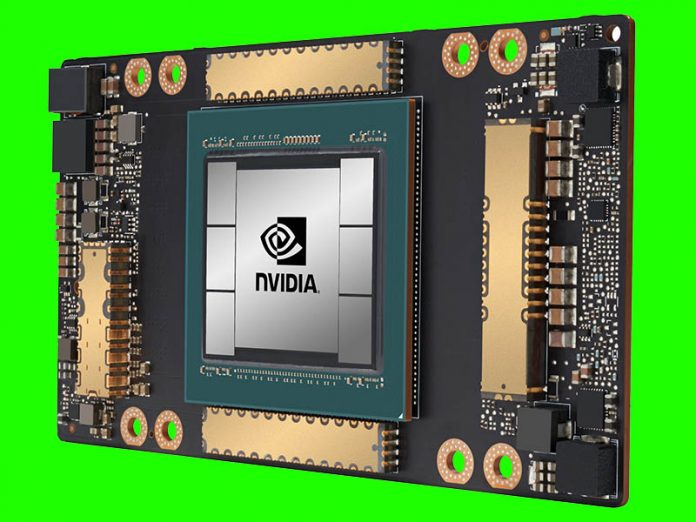

新的NVIDIA A100 80GB将NVIDIA A100的内存容量增加了一倍,这儿,80GB的容量将使我们获得5个16GB HBMe栈。NVIDIA表示,由于产量原因,他们并没有使用你在下图中看到的第六点。

继续阅读

NVIDIA DGX A100成为顶级GPU计算解决方案已有几个月了,在这一代中,NVIDIA的8块GPU的解决方案从2

继续阅读

前几天,NVIDIA A100 GPU已从40GB升级至80GB,今天,我们已经得到了其主要(当前)竞争对手AMD对NVIDIA A100 GPU的回应:Instinct MI100 32GB CDNA GPU。

继续阅读

Google是AI训练的主要力量,设计了自己的加速芯片和系统,既可以用于内部目的,也可以通过Google Cloud平台租用给外部客户使用。

继续阅读