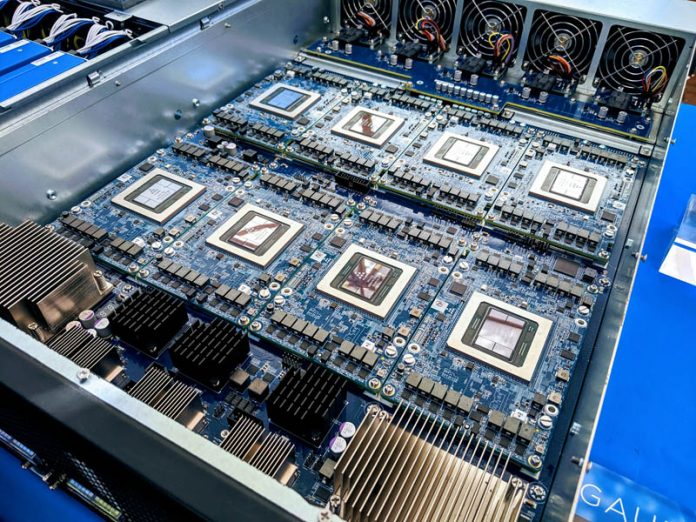

根据IDC的《全球服务器季度追踪报告》,2024年第四季度全球服务器市场收入创下新高,达到773亿美元(约合5595亿元人民币),同比增长91%,成为2019年以来增速第二高的季度。

继续阅读

Google AI TPU

根据IDC的《全球服务器季度追踪报告》,2024年第四季度全球服务器市场收入创下新高,达到773亿美元(约合5595亿元人民币),同比增长91%,成为2019年以来增速第二高的季度。

继续阅读

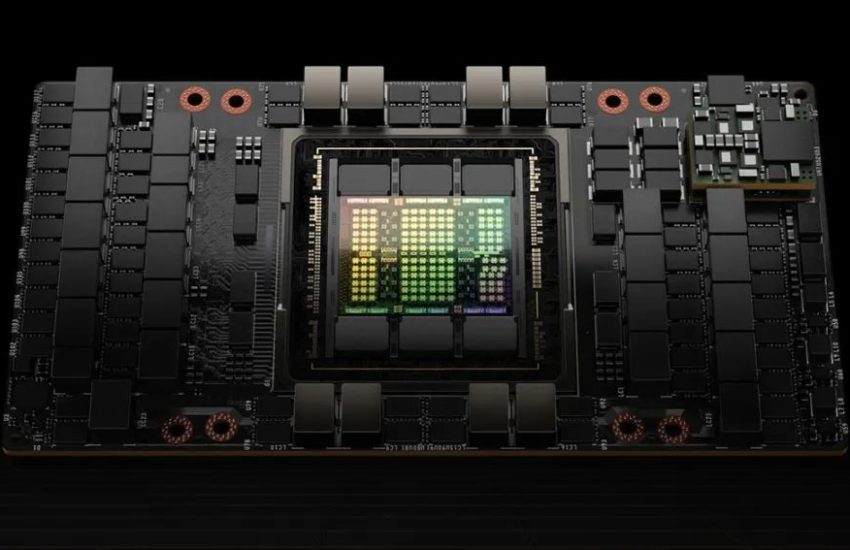

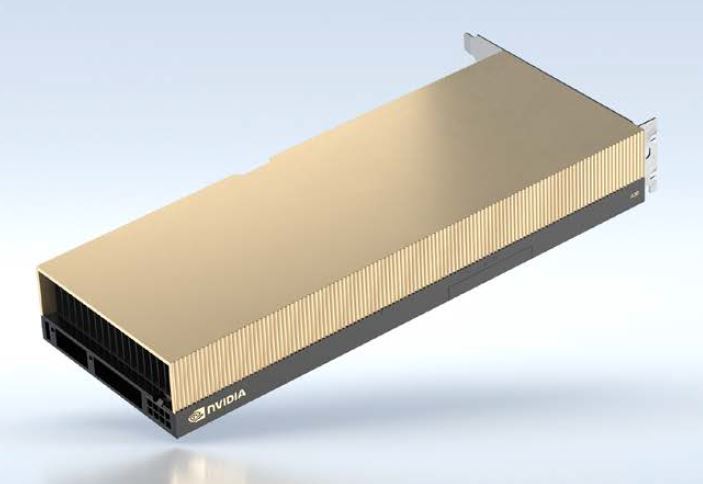

2024年,数据中心市场,英伟达显卡依然一卡难求,已发布的A100、H100,L40S,还有即将发布的H200都是市场上的香饽饽。

继续阅读

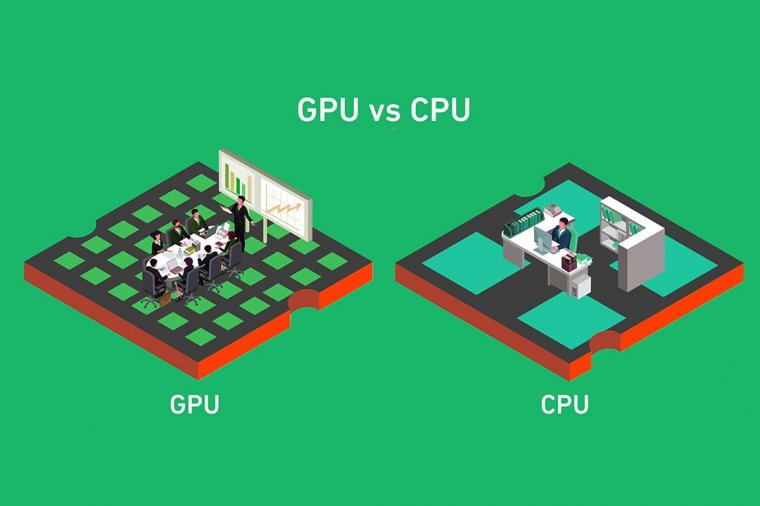

加速深度学习模型的训练和推理过程对于充分发挥其潜力至关重要,而NVIDIA GPU在这方面已经成为改变游戏规则的技术。

继续阅读

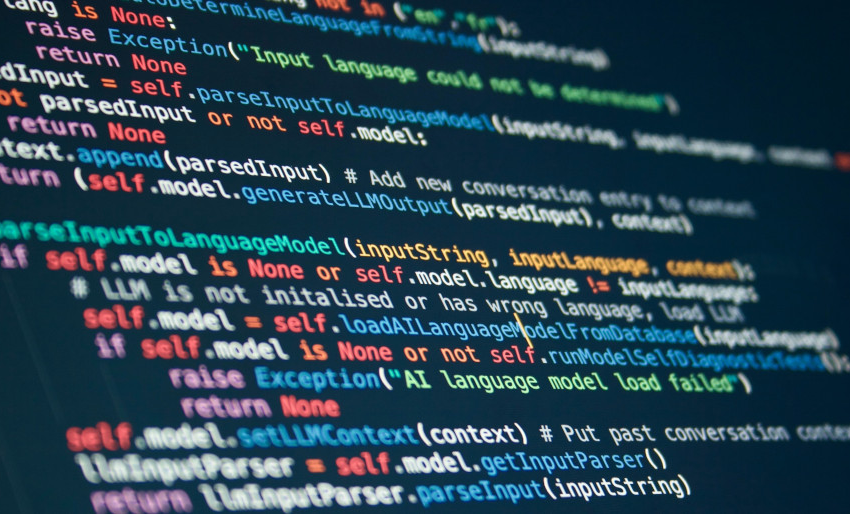

OpenAI公司的ChatGPT在短短一个月内快速风靡全球,人工智能的快速发展,离不开高性能、高算力的硬件支持。

继续阅读

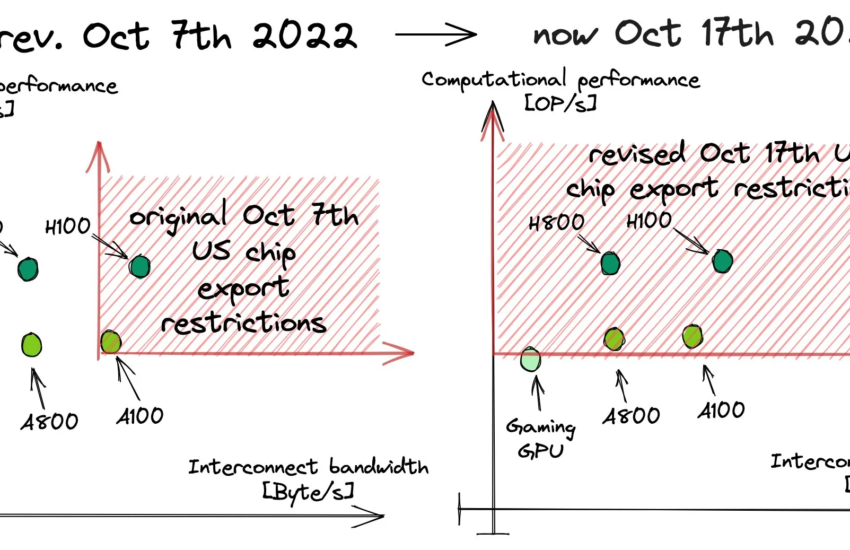

美国政府对21世纪的“冷战”发动了最新的回击,涵盖了AI芯片和晶圆制造设备。

继续阅读

在Google I/O 2023活动中,Google软件产品组合中的生成式AI功能成为焦点,这一点毫不奇怪。

继续阅读

NVLink的目标是突破PCIe接口的带宽瓶颈,提高GPU之间交换数据的效率。2016年发布的P100搭载了第一代NVLink,提供160GB/s的带宽,相当于当时PCIe 3.0 x16带宽的5倍。

继续阅读

展望2023,企业AI应用蓬勃兴起,数据海洋正逐渐涌现而出

继续阅读

在GTC 2021上,有很多与GPU相关的公告,我们的测评还没有涵盖最新的NVIDIA A30,我们发现A30是我们特别感兴趣的产品,本文我们来讨论一下NVIDIA A30。

继续阅读

12月3日消息,亚马逊(Amazon)云计算业务部门AWS与英特尔官网的信息显示,亚马逊弹性计算云(EC2)实例将采用英特尔旗下Habana Labs的Gaudi加速器。

继续阅读