HDD的每TB带宽一直在下降。这迫使数据中心工程师通过将热(频繁访问的)数据转移到TLC闪存层或过度配置存储来满足其存储性能需求。

继续阅读

2024年NAND闪存基础设施部署预测

我们的预测,AI技术的普及将不断加速,而基于PCIe 5.0的基础设施将为AI工作负载提供稳定、高效的支持。

继续阅读Google AI TPU

我们的预测,AI技术的普及将不断加速,而基于PCIe 5.0的基础设施将为AI工作负载提供稳定、高效的支持。

继续阅读

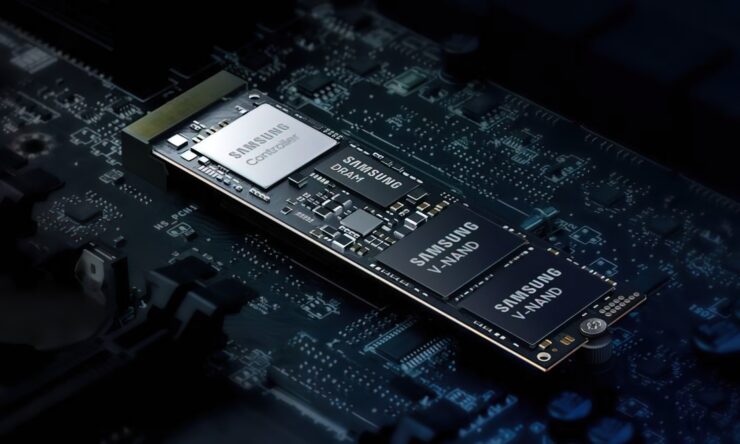

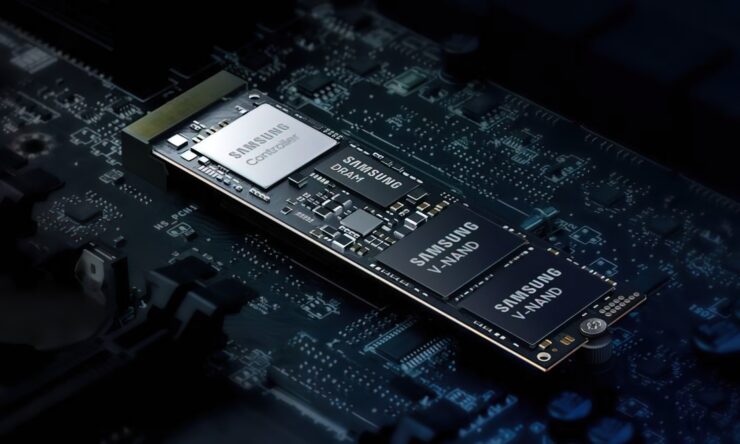

固态硬盘(SSD)已经成为现代计算机领域中的重要组成部分。相比传统的机械硬盘,SSD 具有更快的读写速度和更高的耐用性,这使得它们受到广泛欢迎。

继续阅读

固态硬盘(SSD)已经成为数据存储的重要部分,其高速性能和稳定性让它广泛应用于各类计算设备中。SSD 固态硬盘的接口类型是决定其性能的关键因素之一。

继续阅读

高管和董事层展现出浓厚兴趣,成果明确,且应用速度之快,使得生成式AI(GenAI)成为前所未有的存在。

继续阅读

人工智能、机器学习、量子计算,这些曾经只存在于科幻作品中的技术如今正在塑造智能创新的新时代,其发展速度超出了任何人的想象。

继续阅读

在Linux和Unix系统中,xargs命令是一个非常实用的工具,它可以将标准输入数据转换为命令行参数。

继续阅读

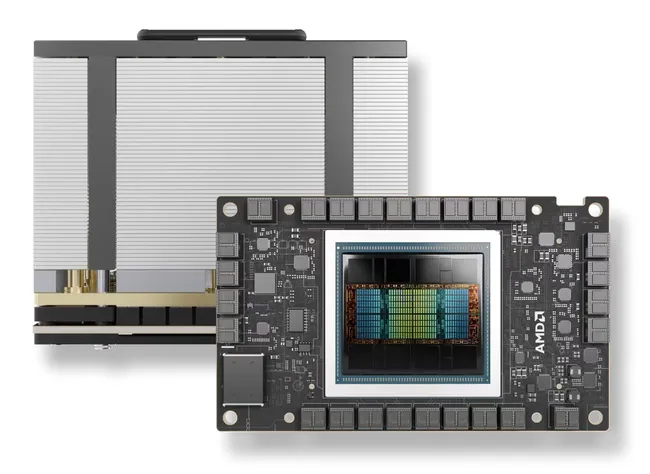

AMD于今年 12 月初发布了MI300X 图形加速器,声称比 Nvidia 的 H100 领先 1.6 倍。

继续阅读

三层交换机是工作在网络层的网络设备,它具备二层交换机的数据链路层功能,同时增加了基于IP地址的路由功能。

继续阅读

以下是我对英特尔周四在纽约举行的“AI无处不在”(AI Everywhere)活动的总结。

继续阅读