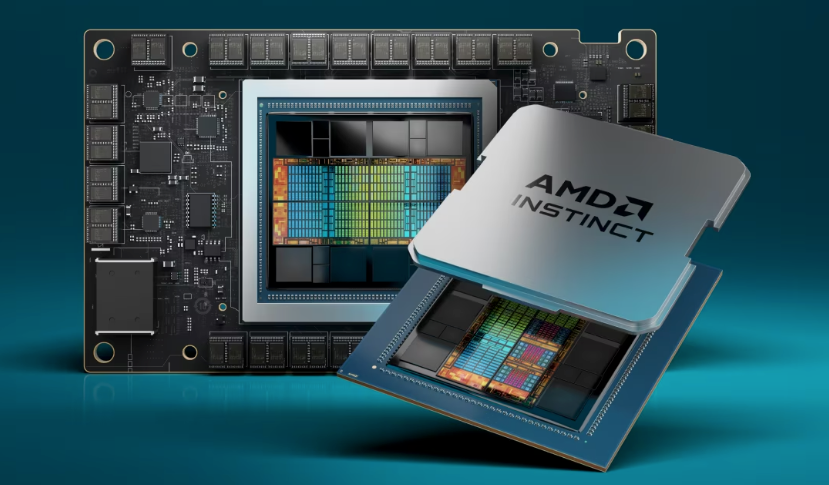

多年来,NVIDIA 在 GPU AI 芯片市场占据主导地位(随着生成式 AI 的出现,该市场在过去 12 个月中出现爆炸式增长),AMD 今天宣布推出期待已久的 MI300X 加速器芯片,AMD 打算成为 NVIDIA 旗舰 H100 GPU 的有力竞争对手。

AMD表示,该芯片具有业界领先的生成式人工智能内存带宽和大型语言模型训练和推理的领先性能,以及AMD Instinct MI300A加速处理单元(APU)——结合了最新的AMD CDNA 3架构和“Zen 4”CPU,适用于 HPC 和 AI 工作负载。

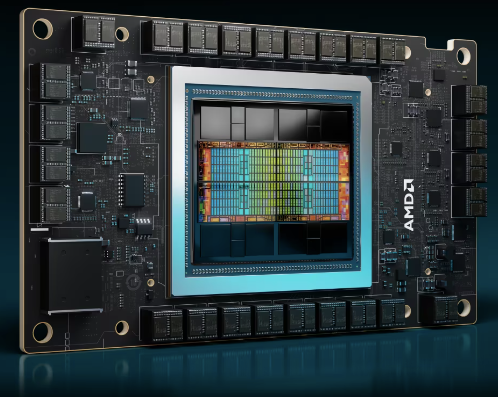

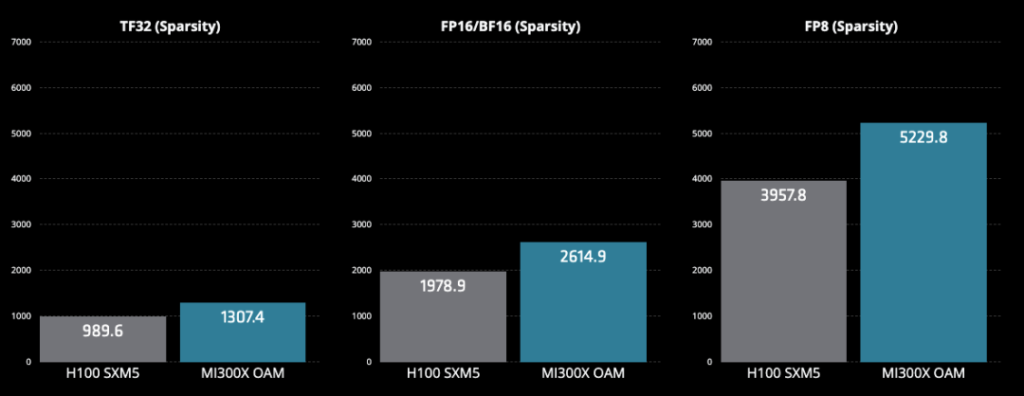

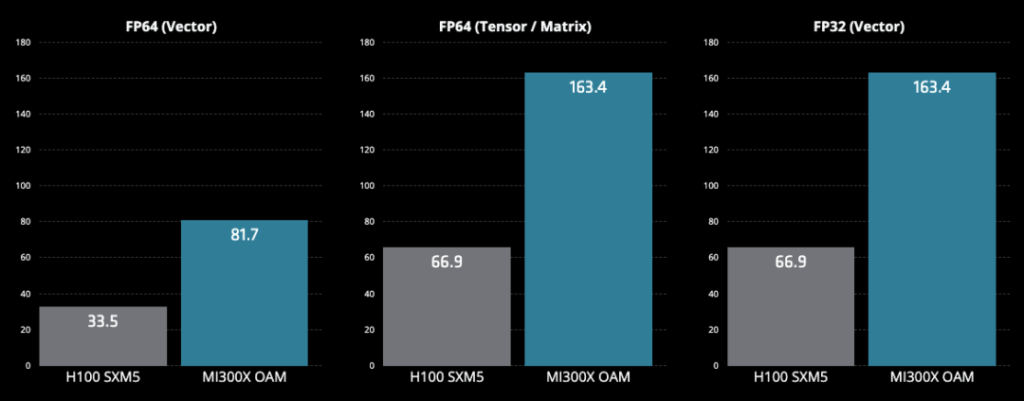

AMD 在其公告中表示,Instinct MI300X 加速器由新的 AMD CDNA 3 架构提供支持,与 Instinct MI250X 加速器相比,新芯片提供的计算单元增加了近 40%,内存容量增加了 1.5 倍,峰值理论内存带宽增加了 1.7 倍,以及对新数学格式(例如 FP8 和稀疏性)的支持。

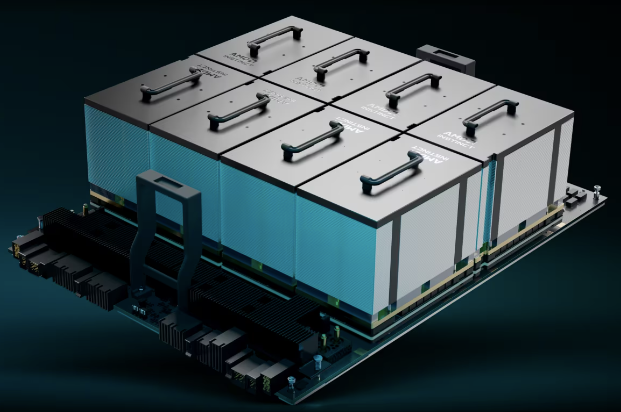

Instinct MI300X 加速器拥有 192 GB 的 HBM3 内存容量以及 5.3 TB/s 的峰值内存带宽。AMD 表示,AMD Instinct MI300X 平台通过第四代 AMD Infinity Fabric 链路将 8 个完全连接的 MI300X GPU OAM 模块集成到行业标准 OCP 设计中,为低延迟 AI 处理提供高达 1.5TB HBM3 容量。其行业标准设计允许原始设备制造商将将 MI300X 加速器添加到现有的 AI 机架和服务器基础设施中,这个可立即简化部署的平台可以加快上市时间并降低开发成本。

AMD 表示,与 Nvidia H100 HGX 相比,AMD Instinct 平台“在 BLOOM 176B 等 LLM 上运行推理时,吞吐量可提高高达 1.6 倍,并且是市场上能够为 Llama2 等 70B 参数模型运行推理的唯一选择,在单个 MI300X 加速器上;简化企业级 LLM 部署并实现出色的 TCO。

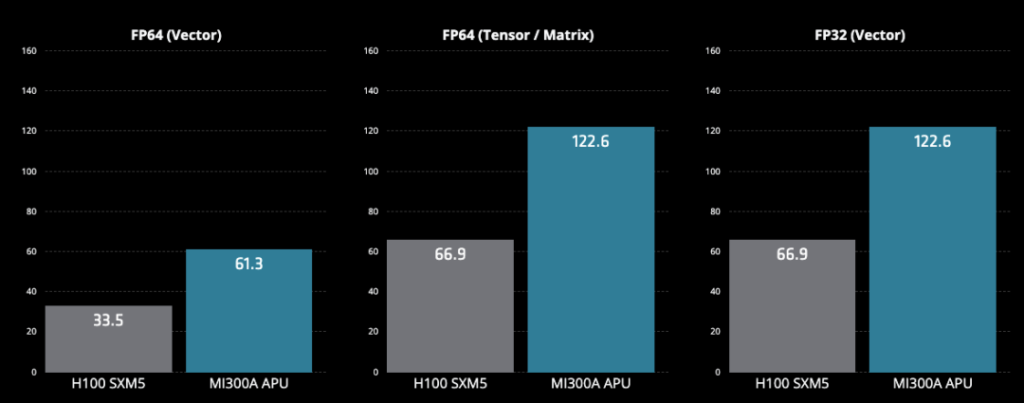

AMD 将 Instinct MI300A APU 称为首款适用于 HPC 和 AI 的数据中心 APU,利用 3.5D 封装和第四代 AMD Infinity 架构。MI300A APU 结合了 AMD CDNA 3 GPU 内核、最新的 AMD“Zen 4”x86 CPU 内核和 128GB 下一代 HBM3 内存,和上一代 AMD Instinct MI250X相比,在 FP32 HPC 和 AI 工作负载上提供约 2.6 倍的每瓦性能。

AMD 表示,MI300A APU 受益于将 CPU 和 GPU 核心集成在一个封装中,并补充说,该公司的目标是从 2020 年到 2056 年,将用于人工智能训练和 HPC 的服务器处理器和加速器的能效提高 30 倍。

AMD Instinct MI300 系列加速器采用AMD最先进的技术设计,可提供领先的性能,并将用于大规模云和企业部署。通过利用领先的硬件、软件和开放生态系统方法,云提供商、OEM 和 ODM 正在将技术推向市场,使企业能够采用和部署人工智能驱动的解决方案。

利用最新 AMD Instinct 加速器产品组合的客户包括 Microsoft,该公司最近发布了新的 Azure ND MI300x v5 虚拟机 (VM) 系列,该系列针对 AI 工作负载进行了优化,并由 AMD Instinct MI300X 加速器提供支持。

此外,El Capitan 是一台由 AMD Instinct MI300A APU 驱动、位于劳伦斯利弗莫尔国家实验室的超级计算机,预计将成为第二台由 AMD 驱动的百亿亿级超级计算机,在完全部署后预计将提供超过 2 exaflops 的双精度性能。

Oracle云基础设施计划将基于AMD Instinct MI300X的裸机实例添加到该公司的AI高性能加速计算实例中。基于 MI300X 的实例计划通过超快 RDMA 网络支持 OCI Supercluster。

几家主要 OEM 厂商还结合 AMD Advancing AI 活动展示了加速计算系统:

- 戴尔展示了配备八个 AMD Instinct MI300 系列加速器的 Dell PowerEdge XE9680 服务器,以及采用 AMD ROCm 支持的 AI 框架的全新戴尔生成式 AI 验证设计。

- HPE 最近宣布推出 HPE Cray Supercomputing EX255a,这是首款由 AMD Instinct MI300A APU 提供支持的超级计算加速器刀片,将于 2024 年初上市。

- 联想宣布为新型 AMD Instinct MI300 系列加速器提供设计支持,计划于上半年上市。

- Supermicro 宣布推出 H13 代加速服务器的新成员,该服务器采用第四代 AMD EPYC CPU 和 AMD Instinct MI300 系列加速器。

AMD还宣布了最新的ROCm 6开放软件平台以及公司向开源社区贡献库的承诺。该公司表示,ROCm 6 软件代表了 AMD 软件工具的重大飞跃,与上一代硬件和软件相比,在 MI300 系列加速器上运行 Llama 2 文本生成时,AI 加速性能提高了约 8 倍。

此外,ROCm 6 还增加了对生成式 AI 的多项新关键功能的支持,包括 FlashAttention、HIPGraph 和 vLLM 等。因此,AMD 拥有独特的优势,可以利用最广泛使用的开源 AI 软件模型、算法和框架(例如 Hugging Face、PyTorch、TensorFlow 等)推动创新、简化 AMD AI 解决方案的部署并释放真正的潜力生成式人工智能。